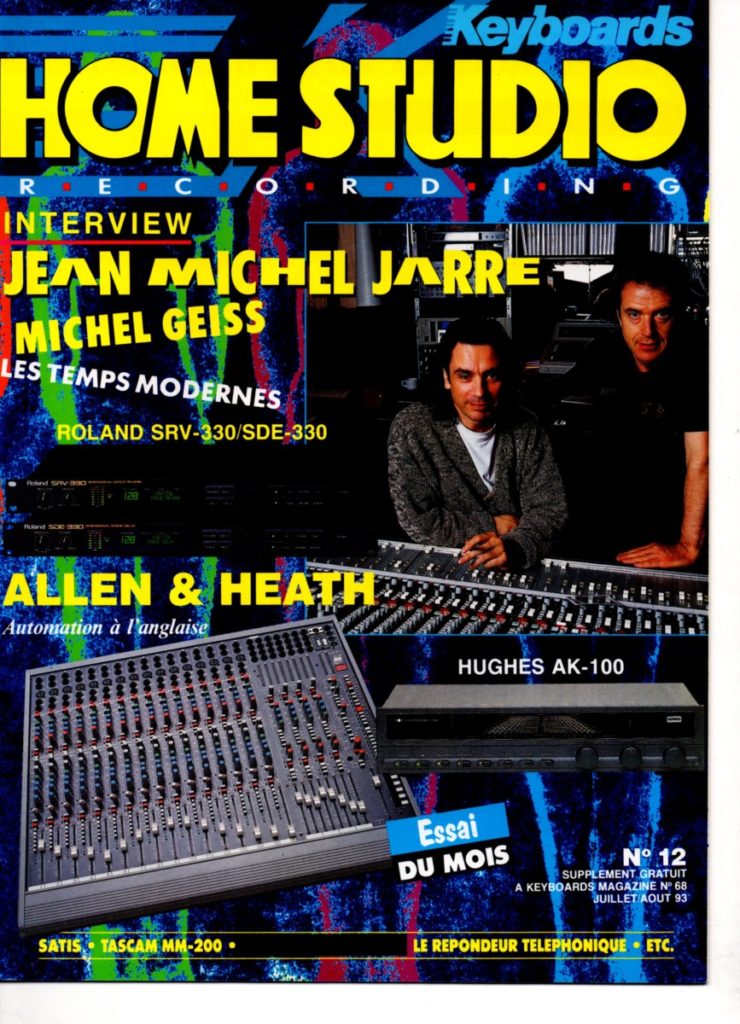

Portrait de Michel Geiss, musicien, ingénieur de mastering et concepteur d’instruments.

Dans le domaine de la musique électronique française, peu de noms bénéficient d’une aura et d’un respect du niveau de Michel Geiss. Au fil des ans, cet ingénieur électronicien de formation est devenu une figure emblématique du paysage musical français. Collaborateur de longue date de Jean-Michel Jarre, musicien, inventeur de machines, ingénieur du son, Michel Geiss est un homme reconnu et respecté. Il nous parle aujourd’hui de son travail d’ingénieur de mastering, de ses projets passés, en cours et futurs.

par Nanisound – SynthFest France

Bonjour Michel. Entre la musique, la conception de matériel musical, l’expertise dans le domaine du son, comment te définirais-tu ?

D’abord peut-être comme quelqu’un qui a eu la chance de vivre plusieurs vies en une seule : électronicien, puis prof en lycée technique, concepteur de matériels et de logiciels, journaliste/pigiste, ingé son et musicien. Autant d’aventures plus passionnantes les unes que les autres. En tant que musicien j’ai composé des musiques pour des projets spéciaux commandés par Gaumont, par le Futuroscope et pour des génériques d’émissions TV. J’ai aussi composé pour moi, dans mon coin, sans vraiment chercher à en faire la diffusion. J’ai juste posté l’une de mes musiques sur Youtube (Michel Geiss – Avatar). J’ai terminé plusieurs morceaux et peut-être qu’un jour je me déciderai à les publier… J’ai aussi eu la chance d’avoir été immergé dans un certain nombre d’aventures musicales, dont celle avec Jean-Michel Jarre qui a duré une vingtaine d’années, à commencer par Oxygène. En m’étant mis à son service, ma collaboration très riche en événements multiples a été autant technique que musicale.

Petite anecdote récente : je viens de travailler avec Dominique Perrier qui m’a demandé de réaliser le mastering du nouvel album de Space Art (Space Art – Entrevues – 2020). Space Art fait partie des légendes de la musique électronique depuis Onyx. Ce travail a donc été pour moi une sorte de « bouclage de la boucle », entre ma longue immersion dans la musique électronique et ma nouvelle vie de prestataire de mastering, de même qu’un retour indirect dans l’univers de Jean-Michel Jarre. Dominique a en effet également collaboré pendant longtemps avec lui sur ses albums, ses concerts et même avant.

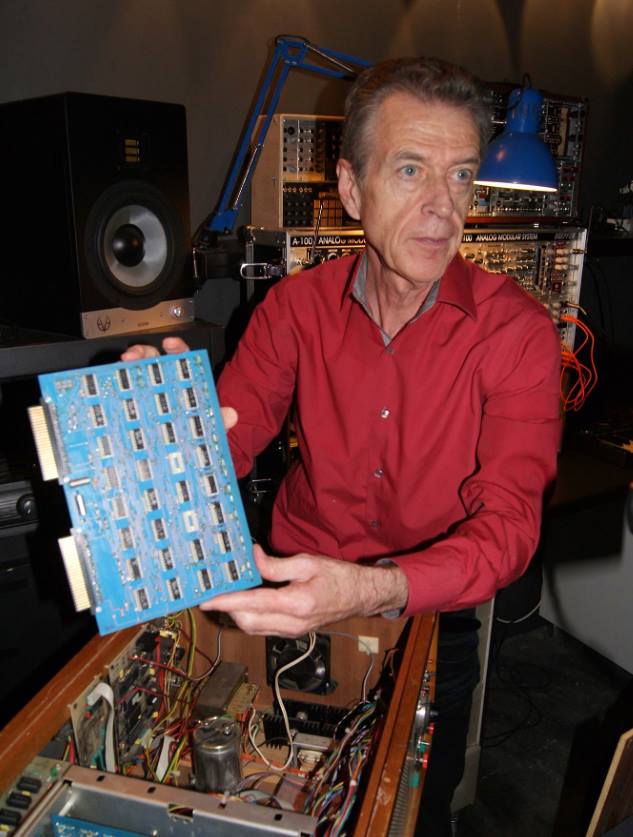

En parallèle, ma formation d’électronicien m’a permis de créer de nouveaux matériels, ainsi que des modifications de matériels existants. Entre autres, je considère la création de mon séquenceur, le Geiss Matrisequencer 250 comme une sorte d’emblème de mon activité d’électronicien/musicien. On parle assez peu de la boîte à rythmes que j’ai aussi créée, le Rythmicomputer qui a pourtant été utilisée dans Équinoxe. Je me suis également lancé dans la création de logiciels musicaux. Je considère en fait que toutes mes activités sont très liées, y compris pour mon travail de mastering pour lequel la compréhension de la musique joue un rôle essentiel, en même temps que le goût pour le son. Cela entre autres quand on me demande de créer des versions « radio » raccourcies à partir de versions « album » plus longues. Il faut alors repérer les temps dans les mesures, faire les jonctions aux meilleurs endroits et quelquefois faire preuve de créativité musicale pour même éventuellement restructurer différemment une chanson.

Ne penses-tu pas que les synthétiseurs ont souvent une interface trop technique pour un musicien ?

Pour aborder la synthèse et tirer le meilleur d’un instrument électronique, il est préférable de connaître certaines bases techniques. Effectivement il serait possible de concevoir des instruments à réglages plus simples, globalisés, avec moins de fonctionnalités. Il est vrai que la technique a parfois pris le pas sur certains aspects d’ergonomie. Quand on a commencé à proposer des synthétiseurs un peu avant les années 70, on a d’abord cherché une adhésion rapide des musiciens. Les instruments électroniques étaient basés sur un clavier de type “piano”. Dès les premiers synthétiseurs, on a donc orienté l’approche de la synthèse vers une utilisation la plus large possible. Pour ce qui est des réglages, on a vu se développer différents principes. On a maintenant de plus en plus de presets sur les synthétiseurs. Je trouve cette approche tout à fait justifiée puisqu’un synthétiseur moderne est à même de produire énormément de sons différents, sans parler des effets qui eux étaient absents des modèles anciens, mise à part la reverb à ressorts.

Avec actuellement autant de richesse dans la production de sonorités différentes, il est difficile d’organiser l’ergonomie sur seulement quelques réglages. La question est effectivement légitime et on pourrait concevoir des synthétiseurs plus simples. Mais j’ai l’impression que les musiciens ont un besoin tout autant légitime d’être respectés dans leurs capacités à créer des sons dans un environnement pas trop simpliste et ils ont raison. On ne doit pas les considérer comme des débutants. Au contraire, il faut à mon avis les voir comme des gens éduqués qui savent ce que sont un synthétiseur et ses principes. Je ne suis pas sûr que la majorité des musiciens seraient satisfaits d’une approche minimaliste avec seulement quelques réglages. Concernant les presets, je me souviens des premières années de mon travail avec Jean-Michel Jarre où il fallait consacrer une partie de notre temps à noter précisément les réglages d’un son qu’on avait peur de perdre par la suite !

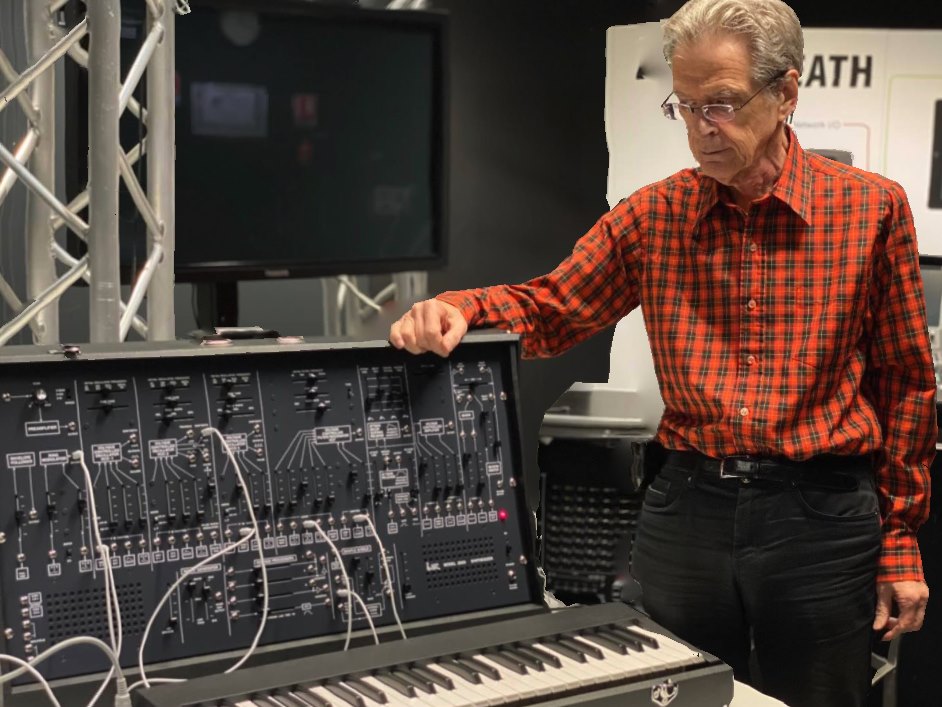

Tu es l’un des spécialistes de l’ARP 2600 et à ce titre, quel est ton regard sur l’engouement actuel que suscite cette machine ?

L’une des raisons est dans le fait que c’est un instrument réellement légendaire. Il a fait rêver pendant longtemps, y compris moi-même quand il est apparu, et c’est toujours le cas pour beaucoup d’autres que moi. L’une des raisons vient aussi du fait qu’il a une sorte de « personnalité », par son aspect physique et son grand panneau de réglages incliné. Au même moment, les modulaires Moog, faits d’assemblages de modules reliés par des quantités de câbles avaient plus l’allure de gros Lego électroniques. Parmi les anciens de la synthèse, l’ARP 2600 n’est d’ailleurs pas le seul à susciter un regain d’intérêt, mais contrairement à d’autres, il a aussi un autre avantage : celui d’être très pédagogique. Quand on a quelques notions de synthèse soustractive et qu’on regarde la face avant, on comprend immédiatement sa structure de synthèse. Le succès du 2600 n’est donc pas seulement dû à la légende ou au son mais aussi à la simplicité de son interface. Ce n’est peut-être pas un hasard que la série limitée de la nouvelle fabrication par Korg ait été vendue immédiatement en totalité !

En fait, le son du 2600 a varié au long de sa carrière. Il y a eu le modèle gris avec le filtre Moog, puis ensuite le modèle orange avec un autre filtre qui sonnait différemment. C’est vraiment son visuel et sa grande clarté d’utilisation qui ont donné à cet instrument sa particularité. Une autre raison de son succès est bien sûr la liste prestigieuse de ses utilisateurs, réellement impressionnante. D’autres comme Pink Floyd se sont plutôt tournés vers l’AKS ou le VCS3, mais les synthés EMS n’ont pas déclenché la même frénésie ni le même respect que le 2600. Le VCS3 se re-fabrique un peu aujourd’hui, sur commande, mais ce n’est pas le même engouement. Concernant le 2600, je pense vraiment que la légende qui l’entoure est toujours dans l’esprit de beaucoup de musiciens. Je pense d’ailleurs avoir contribué humblement à l’avoir fait connaître en France par un très long article que j’ai écrit dans le magazine « Le Haut-Parleur » (1974) et par une conférence à Télédiffusion de France pour l’AES à Issy les Moulineaux, avant de connaître Jean-Michel Jarre qui, je l’ai appris plus tard, habitait tout près de là, à Vanves à cette période ! J’aime raconter que c’est à la suite de cette conférence qu’on m’a mis en contact avec lui. Pour cette raison, l’ARP 2600 reste pour moi le symbole d’un grand tournant dans ma vie.

La profusion actuelle de synthétiseurs aboutit à beaucoup de produits qui se ressemblent. Et comme tu le soulignes, le 2600 doit une grande partie de son succès à son interface. Un nouveau produit doit-il aujourd’hui se démarquer par son interface ou par ses sons ?

Les deux à la fois. Dans un synthétiseur, le son et l’interface sont deux choses essentielles et complémentaires. Nos yeux et nos oreilles s’influencent l’un l’autre. Les musiciens vont décider d’utiliser un synthétiseur sur la base des sons qu’il produit, mais également par rapport à son apparence, à son approche et à son attrait. Deux types d’interfaces coexistent aujourd’hui : celle de l’instrument hardware, où l’on a envie de toucher de vrais boutons, de manipuler de vrais sliders. Et puis on a le logiciel où l’interface c’est l’écran, où la présentation, les couleurs, les graphismes font que l’instrument aura plus ou moins d’attrait.

Nous sommes des êtres humains. Nous sommes sensibles à l’aspect autant qu’aux fonctionnalités On peut aussi noter qu’en lutherie virtuelle, certains standards graphiques et ergonomiques se dégagent et évoluent. Actuellement la mode est aux écrans sombres, avec des réglages assez discrets. Logic Audio est un bon exemple de cette évolution. Son apparence a beaucoup changé et il ressemble aujourd’hui à un synthétiseur logiciel « tendance ». L’arrivée des écrans tactiles a permis de relier en partie le visuel au manuel. Dans la création musicale, le son et le visuel marchent ensemble. Mais le son reste prioritaire bien sûr. Il est à cet égard intéressant de se rendre compte aujourd’hui de l’importance du visuel dans le mixage.

Dans la production musicale actuelle, a-t-on remplacé les oreilles par les yeux ?

Dans une certaine mesure, oui en grande partie. Cette dernière décennie, nous avons de plus en plus appréhendé le son par le visuel. C’est tout à fait normal. Lorsque l’on dispose d’écrans, on les regarde pour ce qu’ils indiquent. Observer les éléments du son en même temps que de les entendre a quelque chose de magique en même temps qu’utilitaire. D’ailleurs, un terme décrit la sensation de l’écoute simultanée de la musique et sa représentation visuelle : la « synesthésie » qui veut dire « sensations simultanées ». Il existe bien un plaisir à voir ce qu’on entend, de même que l’inverse. Dans un autre domaine, les lumières ou les lasers rythmiques en discothèques ont un effet similaire.

Dans mes souvenirs des années 70, on travaillait sans écrans et avec de vraies consoles. Nous disposions seulement de faders et de potentiomètres, et nous étions totalement concentrés sur le son. Nos indications visuelles étaient simples : la position des faders, des EQ, et seulement des vu-mètres pour contrôler les volumes. Après avoir vécu cette période et qu’on a vu les écrans arriver dans les studios, on peut légitimement penser que la nouvelle génération née dans l’univers du son visuel peut difficilement imaginer cette façon de travailler « en aveugle », pourtant plus musicale, plus intuitive. Il s’agit de deux manières différentes d’aborder le son, avec des implications difficiles à évaluer entre l’une et l’autre sur le résultat artistique. Comment avoir du recul sur un mix quand on a travaillé des heures devant son écran Pro Tools sur des corrections vocales ou des edits de mise en place ?

Un exemple qui me semble intéressant et que j’ai vécu sur une fin d’album avec Laurent Voulzy dans son studio : à la fin des mixages, il avait tout éteint, tous les éclairages et tous les écrans. Juste l’écoute de la musique dans l’obscurité, pour pouvoir se concentrer sur le son et repérer ce qui aurait pu passer inaperçu

Peux-tu nous parler de ta collaboration avec Laurent Voulzy ?

Laurent Voulzy est musicien avant tout, mais il est également très concerné par la technique et toutes les étapes de la production. Il intervient dans toutes les étapes d’un mixage en donnant beaucoup d’importance aux moindres détails. C’est un perfectionniste et il va jusqu’au bout du possible pour tenter d’approcher la perfection. Concernant son style, en particulier dans son dernier single (Laurent Voulzy – Loreley, Loreley – 2020), il a inclus beaucoup de chœurs. Depuis quelque temps, il aime superposer les couches vocales, doublages, harmonies et chœurs. Peut-être sa fréquentation des cathédrales ? Je le connais depuis longtemps, surtout depuis l’album « Avril » (Laurent Voulzy – Avril – 2001). Laurent Voulzy est très attentif à ce qui se passe dans le studio. Il sait où il va. Ses musiques sont le reflet de ce qu’il a en tête. C’est est un musicien complet, un créateur, un artisan de la chanson. En fait, j’ai le sentiment que pour lui, une chanson c’est presque encore plus de la musique que de la chanson, même s’il est très vigilant sur chaque détail des textes. En tout cas, j’ai toujours eu beaucoup de plaisir à travailler avec lui.

Parle-nous un peu de ton métier d’ingénieur de mastering. Entre les fameux “on rattrapera au mastering” et “si le mixage est bon il n’y a rien à faire”, comment comprendre et expliquer ce vaste et mystérieux domaine ?

Pour ma part, j’ai commencé cette activité après le changement d’équipe de Jean-Michel Jarre et l’arrêt de ma collaboration. En tant que spécialiste de la synthèse et après une activité multi-horizons avec lui, ce n’était pas une décision évidente, mais plutôt un choix le plus adapté à mes dispositions et à mes connaissances. Et j’avais bénéficié d’une première approche du métier dans des studios prestigieux aux USA. Depuis qu’il s’est largement démocratisé avec l’arrivée de multiples outils dédiés, le mastering est maintenant bien mieux connu et compris que lors de ses débuts. Chacun peut faire du mastering, selon ce qu’il en attend et ce qu’il en espère. Mais pour garder la musicalité en même temps qu’on tente de rivaliser en volume sonore avec les autres productions, c’est une autre histoire !

On peut voir le mastering soit comme un métier à part entière, soit comme un simple complément du mixage, parfois même intégré à celui-ci, directement en sortie de console. C’est souvent vers le premier des deux concepts que les gros projets sont dirigés, alors que le 2ème cas est plus fréquent avec les productions plus économiques. L’ingénieur de mastering porte une lourde double responsabilité : celle de tirer le meilleur d’un investissement quelquefois énorme en travail, en talents et en finances. C’est tout cela qu’on a entre les mains et j’y pense souvent. Il m’arrive de me trouver des allures de kamikaze dans ce métier, surtout quand je sais que certains de mes projets ont été fabriqués à ces centaines de milliers d’exemplaires (plus d’un million pour l’un d’entre eux).

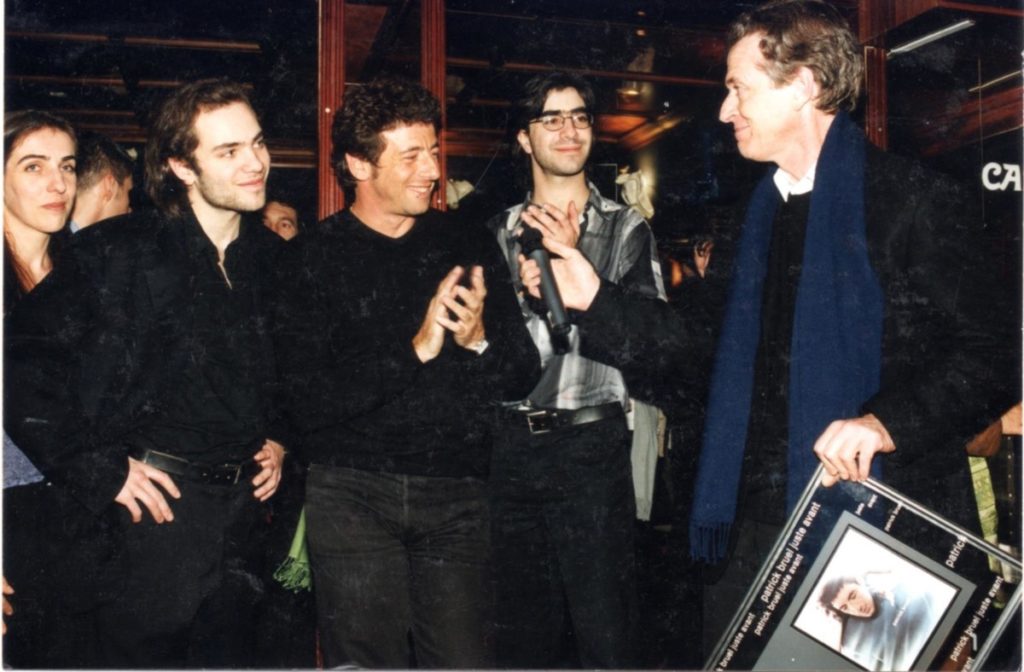

Souvent, le master est vérifié par d’autres, mais pas toujours, y compris parfois pour les plus gros albums. Une erreur se voit multipliée par le nombre d’exemplaires fabriqués et peut donc être catastrophique. Exemple de situation stressante : à la fin de mon travail de mastering de l’album « Juste avant » de Patrick Bruel (Patrick Bruel – Juste avant – 1999), j’avais terminé le master. Un coursier arrive pour le prendre et le livrer à BMG. Le téléphone sonne. C’était Patrick Bruel qui me demandait une légère modification sur une EQ dans le médium pour l’une des chansons. J’ai fait attendre le coursier et j’ai recommencé entièrement le master qui est directement parti tel quel à l’usine de pressage sans vérification.

Il serait utile de définir le mot « mastering ». Celle que je propose est « l’ensemble des techniques qui permettent d’obtenir un résultat optimum à partir d’un mixage ». C’est vaste, mais cela couvre l’ensemble des matériels et logiciels qui sont utilisés pour obtenir un résultat. Sans parler de l’essentiel : le bon goût.

Face au mastering, on rencontre deux attitudes différentes. D’abord celle des professionnels qui savent pertinemment que le mastering ne va pas permettre de faire des miracles. L’autre approche est celle de ceux qui n’ont pas l’habitude de cette étape et qui en attendent un peu trop. Le mastering n’est pas fait pour rattraper des problèmes de mixage, tout comme le mixage ne peut pas rectifier les erreurs ou les imperfections des enregistrements. Évidemment on peut rétablir certaines choses, comme par exemple un excès de graves, souvent dû au travail sur les enceintes de proximité dont le rendu dans cette zone peut tromper. On peut également rectifier des excès de sibilantes sur les voix (les “s” qui sifflent trop) non traitées au mixage sur la piste elle-même. On peut également éclaircir un peu un mix un peu « sombre » qui manque de clarté. Et très souvent on utilise la compression pour réduire la dynamique et obtenir un niveau moyen plus élevé et produire un son plus « compact », plus dense. Pour simplifier, le mastering consiste à prendre le mixage tel qu’il est et le sublimer, l’optimiser, dans l’optique de le rendre compatible avec une sorte de norme, en accord avec les styles de musique. Le mastering comprend également la détection de certains défauts. Quand on passe des journées entières sur une réalisation, il est difficile d’avoir du recul et des détails peuvent échapper à la vigilance. Il m’est par exemple plusieurs fois arrivé lors d’un mastering de signaler un montage défectueux, ou aussi des clics ou des parasites qu’il m’est parfois difficile d’éliminer.

Il est certain qu’un bon mixage est la meilleure chance d’obtenir un très bon mastering, sans trop d’efforts. Depuis un certain temps, en me confiant un travail, il m’arrive qu’on me demande mon avis sur le mix et il s’ensuit des échanges positifs et constructifs, grâce à l’ouverture d’esprit de certains ingés sons.

Une anecdote à ce sujet : pour le mastering d’un album de Jean-Michel Jarre, j’étais allé travailler à New-York avec Greg Calbi, ingénieur star de mastering américain très connu et respecté. Je lui avais apporté des cigares de la Havane alors encore interdits des ventes aux USA et on avait sympathisé. Du coup, il m’avait raconté un événement marquant de sa carrière. Greg avait obtenu un Grammy Award de mastering pour un album (Concert in Central Park – Simon & Garfunkel – 1981). Il m’a fait un aveu : “ Cet album était tellement bien fait que j’ai uniquement monté le fader du volume, et … c’est tout. Et j’ai eu un Award pour ça ! ”. Cette petite histoire en dit long ! Elle est très instructive : quand on pratique le mastering, il est essentiel de garder à l’esprit que le but n’est pas d’intervenir à tout prix. Cela peut même parfois être plus destructeur que bénéfique pour le résultat. Si le mixage est bon, les pistes correctement traitées, compressées de façon adéquate et nettoyées des bruits divers il est inutile ou même dangereux de vouloir intervenir.

Le serment d’Hippocrate en médecine, « Premièrement ne pas nuire » devrait aussi s’appliquer au mastering. Il m’est arrivé plusieurs fois, même avec des mixages corrects, qu’on me demande de refaire des masterings qui avaient fortement déçu, y compris certains issus de grosses structures comme Métropolis ou Sterling Sound. Une preuve que même les références des studios et leur matériel très haut de gamme sont insuffisants. C’est l’être humain derrière ses machines qui fait la différence.

L’ingénieur de mastering est une sorte de gardien du temple. Il doit savoir faire preuve de sagesse tout comme un médecin ne doit pas tenter de faire croire à ses compétences par des prescriptions abondantes. Il faut seulement savoir s’il faut travailler sur l’égalisation, creuser un peu le bas-médium, intervenir sur d’autres gammes de fréquences, compresser, ou tout simplement ne rien faire en dehors d’une optimisation du volume. Savoir prendre de la distance sur un projet en étant extérieur à la réalisation, et avoir le recul nécessaire pour un avis objectif sont essentiels. En enregistrement ou en mixage, en passant des heures ou parfois des jours sur une chanson, l’oreille s’habitue à tout, y compris à des erreurs. C’est humain et c’est l’une des raisons de l’intérêt de passer par quelqu’un d’extérieur pour le mastering.

Un autre facteur important est bien sûr également les écoutes du studio de mixage. D’autres enceintes, comme celles d’un studio de mastering peuvent faire constater des déséquilibres. Pour cette raison, les mixeurs pro travaillent principalement sur une seule paire d’enceintes, mais vérifient aussi le résultat sur des modèles différents, ou même au casque. En mastering le contexte est différent puisque le mixage est en principe livré terminé. C’est donc un avantage de pouvoir passer par un autre studio pour l’étape finale du mastering. Malgré les apparences, le mastering est en réalité un sujet très vaste et très complexe. Il m’arrive d’ailleurs de donner des formations sur ce travail.

En plus de ton travail d’ingénieur de mastering, tu sembles être un spécialiste dans le traitement des voix. Quelle est la part de technique, et quelle est la part artistique dans ce travail ?

La voix, c’est le pilier d’une chanson. Tout le reste en dépend. Les grands arrangeurs le savent bien et ils ont l’art de la façon « d’habiller » une voix en fonction de son timbre et de son expression. Ils sont des spécialistes du costume musical « sur mesure ». C’est un talent. Ensuite, c’est au mixage qu’on cherche à exploiter la voix de la meilleure façon.

C’est toujours délicat de donner un avis artistique sur une production quand on est l’ingénieur de mastering. Mais quand je sais que je peux le faire, il m’arrive de proposer qu’on me fournisse la voix et la musique séparément. Très grosse responsabilité, mais je procède parfois de cette manière. Je suis par exemple intervenu sur des albums de Laurent Voulzy, d’Alain Souchon, de Chimène Badi et d’autres, pour lesquels j’ai travaillé le son de la voix séparément pour ensuite la réintégrer dans le mix. Le fait de pouvoir la travailler séparément est un avantage pour le résultat, puisque qu’avec un mix complet il est impossible d’en améliorer le son sans affecter le résultat global.

Ce travail séparé sur les voix est aussi un gros challenge, puisqu’un volume de voix un peu trop faible rend la chanson moins vivante, alors que s’il est légèrement trop fort, il va masquer la musique. A 1 db près, voire même moins, la différence est sensible. C’est très délicat. Lorsque j’ai travaillé sur l’album de Chimène Badi (Chimène Badi – Entre nous – 2003), son producteur Rick Allison m’avait d’abord demandé de faire le mastering à partir du mix. Je lui ai alors expliqué qu’il aurait été intéressant de disposer de la voix séparée pour ce projet. Il n’avait pas pensé à cette option, mais ses remerciements lors du rendu final m’ont donné raison.

J’ai récemment travaillé sur un album de Vika Yermolyeva (Vkgoeswild – Happiness is not the point – 2020) et au départ du projet, je trouvais sa voix émotive et poétique, mais sous-mixée. Il me semblait nécessaire de devoir traiter la voix à part, compression et égalisation et de revoir le volume séparément pour améliorer le résultat, en adéquation avec le principe artistique global du projet. Tout récemment, j’ai aussi eu beaucoup de plaisir à travailler avec Hervé Brault, réalisateur du nouvel album d’Aude Henneville pour lequel il m’a confié le traitement des voix. Le jugement artistique est omniprésent dans le travail de mastering, avec parfois mon regret de ne pas pouvoir intervenir sur des éléments auxquels je n’ai pas accès.

Suivant les formats (CD, vinyle, etc.) y-a-t-il des mastering différents ?

Aujourd’hui on assiste à un vrai revival des sorties du vinyle. On me demande régulièrement de faire des masters pour ce format. Le vinyle n’a pas du tout les mêmes caractéristiques, les mêmes nécessités, et les mêmes prérequis que le CD. Avec le CD tout est permis. On peut mettre beaucoup d’aigus, beaucoup de graves, on peut mettre les graves à gauche ou à droite. La durée n’est pas un problème jusqu’à 74 minutes ou plus. Le vinyle a lui de nombreuses contraintes. Par exemple, le vinyle accepte très mal les “s” trop présents, l’excès d’aigus, et les graves décentrés ou déphasés. Il faut savoir que la gravure des sillons est réalisée simultanément sur la largeur et la profondeur, sur 2 faces du sillon en angle droit, l’une pour le canal gauche et l’autre pour le droit. S’il est mal contrôlé, en partie avec des graves non maîtrisés, un mouvement vertical en excès peut produire des interruptions du sillon, et des sauts de la tête de lecture lors de l’écoute.

Pour un mastering de vinyle, il m’arrive de modifier les fichiers destinés au CD pour les rendre compatibles avec la gravure, par exemple en coupant les aigus au-dessus d’une certaine fréquence, ou bien en réduisant les sub-graves pour prendre en compte les contraintes d’optimisation du sillon. La gravure d’un vinyle et la réalisation de fichiers numériques sur un CD ou pour les plateformes numériques sont des mondes très différents. Certaines usines de pressage acceptent tous les fichiers même s’ils ne sont pas directement compatibles. Aux risques et périls du demandeur ! On peut maintenant commander des pressages en petites quantités. Sur les sites de commande on peut trouver les recommandations d’optimisation, mais mieux vaut assister sur place à cette étape spécifique au vinyle quand c’est possible. Certaines maisons de disques refusent d’assumer la responsabilité de la prise en charge de ce travail et demandent la fourniture d’un master directement utilisable, notamment préparé par un studio professionnel. Dans tous les cas, il est important de se renseigner.

Le principe de réduction de bruit du vinyle en même temps que la réduction des graves lors de la gravure consiste à augmenter fortement les aigus et les réduire lors de la lecture. Tout cela est normalisé selon la courbe du standard RIAA. Beaucoup d’aigus dans la tête de gravure, c’est beaucoup d’échauffement et le risque de déclenchement d’un disjoncteur de protection. Résultat : on doit recommencer la gravure ! Et si le disjoncteur ne s’enclenche pas, c’est la tête de gravure qui peut griller. A plusieurs milliers d’Euros le remplacement, on se méfie ! Autre conséquence, quand les sifflantes sont excessives, l’augmentation des aigus à la gravure peut les faire saturer.

Pour la version vinyle de plusieurs albums je me suis rendu en studio de gravure avec les mêmes fichiers 24 bits que pour le CD. Option luxe, puisque lors du rendez-vous il a été possible d’optimiser le son et le volume sur place. Au passage, c’est aussi à cette étape qu’on peut obtenir un volume maximum (et donc aussi améliorer le rapport signal/bruit). Le challenge est de réussir à occuper au maximum la surface disponible pour obtenir des sillons les plus larges possibles. C’est tout un art, et pour y parvenir, on fait d’abord plusieurs simulations en temps réel et on modifie les réglages au fur et à mesure jusqu’au résultat souhaité.

Peux-tu nous en dire un peu plus sur cette problématique des graves sur un vinyle ?

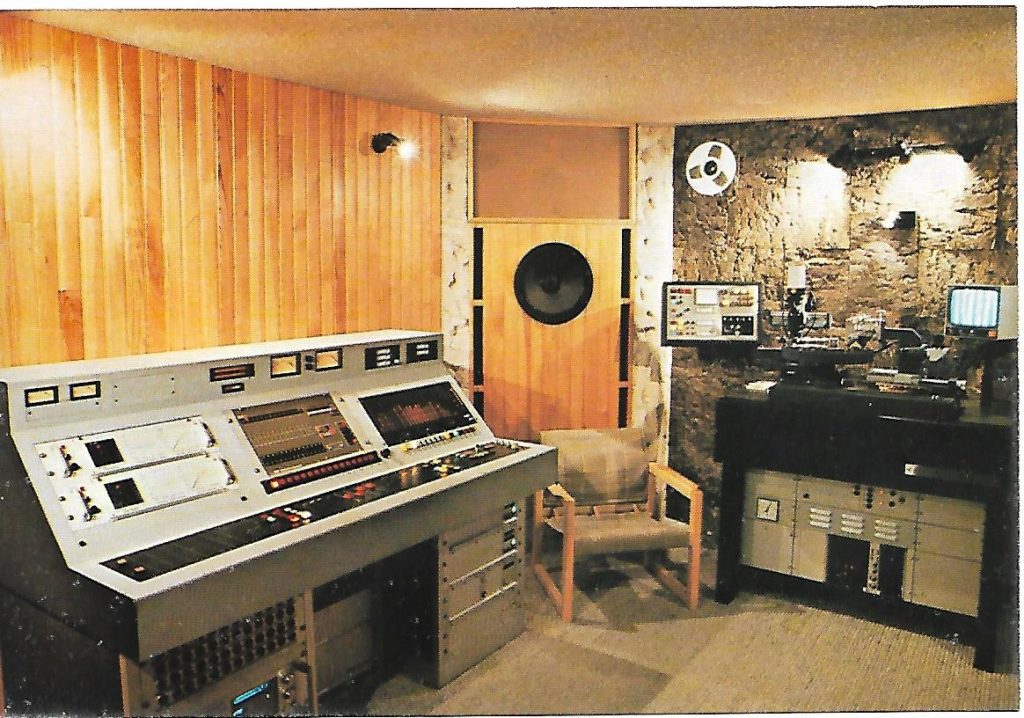

Il est difficile d’entrer dans les détails mais la technique de gravure empêche d’avoir des fréquences basses décentrées. Parmi mes activités d’électronicien, j’avais conçu la console de gravure du studio Dyam Music (Paris) dans les années 80. Elle intégrait un module analogique Neumann dédié au recentrage des graves, l’Elliptical Equalizer. Le risque avec des graves trop décentrés est le saut de la tête de lecture lors de l’écoute. De plus des graves décentrés n’ont pas d’intérêt à l’écoute puisqu’ils ne sont pas directifs, contrairement aux aigus. D’autre part, plus on a de graves dans un mixage, et plus le sillon est large et plus la place occupée réduit la durée totale disponible. C’est pour cette raison que pour obtenir 18 minutes avec un volume acceptable sur une face d’un vinyle 33 tours on admet bien moins de graves et surtout de sub-graves que pour un CD. Pour contourner ces limites, on a eu l’idée de créer le Maxi 45 tours, avec la même surface que celle du 33 tours, donc des sillons plus larges et une durée réduite, pour le gros son des remixes demandé par les discothèques. A noter aussi que pour disposer d’un volume suffisant dans les graves, la profondeur du sillon doit être suffisante et le pressage en adéquation, avec des disques suffisamment épais.

Tu travailles actuellement sur la réalisation d’un synthétiseur logiciel, l’OctoPlus. Peut-on espérer pouvoir l’utiliser bientôt ?

C’est un projet que j’ai commencé il y a plusieurs années, avec Jean Lochard, spécialiste du logiciel Max à l’IRCAM. L’OctoPlus est un synthétiseur logiciel avec une structure de synthèse inhabituelle. Plusieurs types de synthèses sont utilisables ensemble : additive, FM et soustractive. A la base, j’ai eu l’idée de partir d’une synthèse additive. Il s’agit d’un mélange de plusieurs oscillateurs sur lesquels on peut moduler individuellement l’amplitude par des enveloppes. J’ai souhaité que la synthèse additive soit complétée par de la FM appliquée à chaque oscillateur.

Ce concept se base sur huit oscillateurs additifs qui servent de porteuses, et les huit autres oscillateurs de modulateurs. On peut donc faire de la FM sur de la synthèse additive. Et ces oscillateurs additifs, peuvent être configurés suivant trois formes d’ondes (sinus, dent de scie, carrée). Chacun des huit oscillateurs peut au choix être utilisé en mode “synthèse soustractive” ou en mode “FM”. C’est ce qui fait l’originalité du concept. Les oscillateurs de l’OctoPlus peuvent être configurés avec ou sans rapport harmonique. On arrive donc à obtenir des sons soit très “FM”, soit très “analogiques”, ou bien un mélange des deux, des gros sons avec les huit oscillateurs désaccordés, des mélanges avec certains oscillateurs produisant de la FM pendant que d’autres produisent de la synthèse soustractive, des sons inharmoniques, etc. Sur cette idée originale, j’ai conçu une première version qui a été présentée à Ableton (l’OctoPlus est basé sur Max for Live) mais qui avait été jugée d’une approche trop complexe. J’ai donc dans un second temps décidé de reconstruire le projet, avec un accès plus simple, en donnant une plus grande part aux banques de presets, et à leur modification rapide. De là, j’en ai créé beaucoup d’autres, à laquelle s’est ajoutée une petite série créée par Philippe Loiseau (Trajectoire) et une autre par Olivier Aubin, prof à la SAE.

Avec ce projet, j’ai bien conscience d’entrer dans la galaxie des instruments logiciels innombrables et en constante évolution. Mais il s’agit d’un nouveau concept original et j’espère qu’il y trouvera sa place. J’ai d’ailleurs la chance de bénéficier du soutien de Jean-Michel Jarre et de Jeff Rona (cofondateur de la MIDI Manufacturers Association et compositeur de musiques de films à Los Angeles), qui l’ont écouté tous les deux. Par rapport à ma première présentation de l’OctoPlus au SynthFest France, auquel je suis fidèle depuis la première édition, la nouvelle version du logiciel a beaucoup évolué, autant son moteur de synthèse que son interface. La raison du choix de Max vient de ma rencontre avec Jean Lochard, grand spécialiste de Max/MSP et de Max for Live à l’IRCAM, qui s’est chargé de la programmation et a apporté des idées supplémentaires. Suivant l’impact de cette version, je considérerai peut-être la réalisation en Audio Unit, VST et AAX.

Es-tu un adepte du “studio nomade” et quelles sont les nouveautés intéressantes pour toi dans les nouveaux standards audio et la nouvelle lutherie électronique ?

Quand il m’arrive de faire de la musique, c’est toujours en lieu clos, et sur un ordinateur, pas sur une tablette ou un téléphone. Je n’ai donc pas l’expérience des deux façons de composer et il m’est difficile de comparer. La musique nomade est une facilité et un confort. Il est effectivement possible aujourd’hui de produire de la musique à l’extérieur, en voyage, et n’importe où. Pourtant, j’ai toujours en tête l’idée, peut-être préconçue, que pour composer, le meilleur endroit reste le studio. L’idée de “confinement” volontaire est un état propice au fait de créer de la musique. Si des musiciens ont l’envie de composer de la musique de façon nomade, c’est leur choix. Et quoi qu’il en soit, ce n’est ni le mode de travail ni les outils qui importent, c’est le résultat. La volonté de créer et le talent passent avant tout le reste.

Cela dit, par leur encombrement et leur difficulté de transport, certains éléments physiques sont en faveur du mode de travail fixe. Exemple : parmi les dernières nouveautés techniques pas toujours faciles à transporter, je vois le MPE (MIDI Polyphonic Expression) comme une vraie évolution. Avec lui, on a maintenant la possibilité d’agir sur des paramètres de façon très expressive et créative. Associés au MPE, les nouveaux claviers expressifs (ROLI, Continuum, Osmose, etc.) sont des produits qui apportent réellement beaucoup à la musique. L’OctoPlus intègre d’ailleurs le MPE et l’avenir des instruments de musique électronique se situe à mon sens dans l’intégration de ces nouveaux modes d’expression. Et bien sûr, la composition itinérante rend difficile d’emporter les grands claviers.